Validador de Robots.txt

¿Qué Es Robots.txt y Por Qué Es Clave para el SEO?

El archivo robots.txt actúa como un mapa de instrucciones para los motores de búsqueda. Ubicado en la raíz de tu dominio (ej: tudominio.com/robots.txt), controla qué secciones pueden rastrear los bots. Una configuración adecuada puede:

- Proteger contenido sensible y privado de ser indexado.

- Optimizar el presupuesto de rastreo, asegurando que los motores de búsqueda se centren en las páginas más importantes.

- Evitar la indexación de páginas duplicadas que pueden perjudicar el SEO.

- Mejorar la eficiencia del servidor al reducir la carga de solicitudes innecesarias.

Errores Comunes en Robots.txt que Dañan tu SEO

Labrika detecta estos fallos frecuentes que pueden afectar negativamente el rendimiento de tu sitio:

- Sintaxis incorrecta: Falta de dos puntos entre directivas, lo que impide que los motores de búsqueda comprendan las instrucciones.

- User-agent vacío: Reglas sin especificar el bot al que se aplican, lo que puede llevar a que se ignoren.

- Rutas mal formateadas: Ausencia de "/" inicial en las rutas, lo que puede causar que las directivas no funcionen como se espera.

- Límites excedidos: Más de 2048 reglas o 500KB de tamaño de archivo, lo que puede llevar a que algunas reglas sean ignoradas.

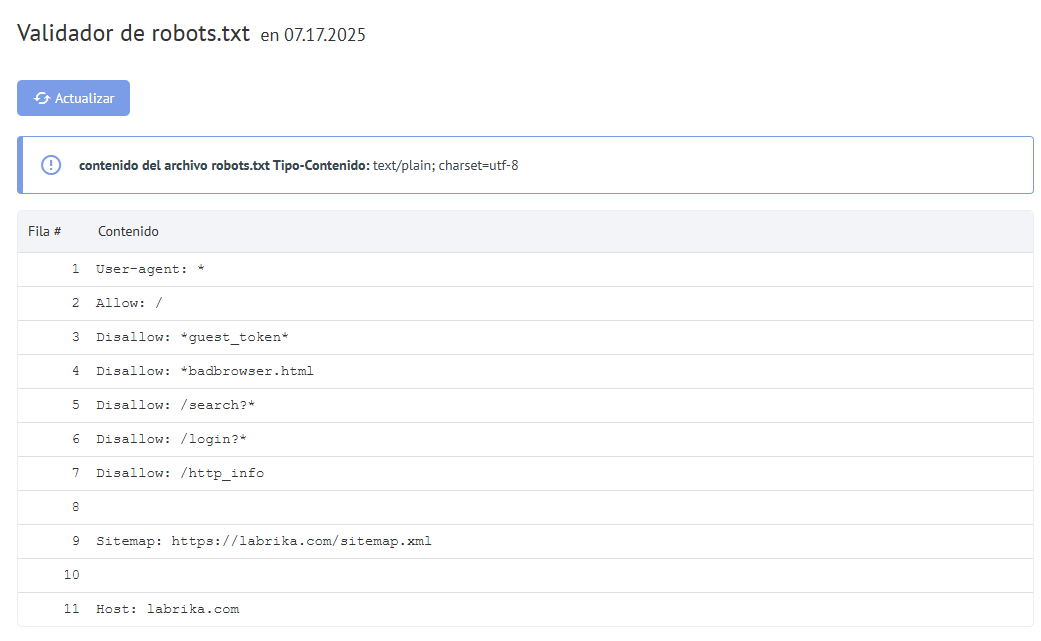

Cómo Usar el Validador de Robots.txt de Labrika

Nuestra herramienta identifica 12 tipos de errores críticos en tu archivo robots.txt. Aquí hay un ejemplo de error común:

Ejemplo de Error en Directivas

User-agent Googlebot

Disallow: /admin

Solución: User-agent: Googlebot

Disallow: /admin

Mejores Prácticas para Configuraciones Efectivas

Para asegurar que tu archivo robots.txt esté optimizado, considera las siguientes mejores prácticas:

- Usa

User-agent: *para reglas globales que se apliquen a todos los bots. - Prioriza

DisallowsobreAllowpara evitar que contenido no deseado sea indexado. - Incluye siempre tu sitemap para facilitar el rastreo:

Sitemap: https://tudominio.com/sitemap.xml.

Optimización Avanzada de Robots.txt

Para sitios complejos, considera las siguientes directivas avanzadas:

| Escenario | Directiva Recomendada |

|---|---|

| Bloquear archivos PDF | Disallow: /*.pdf$ |

| Permitir solo imágenes | Allow: /*.jpg$ |

| Bloquear acceso a secciones administrativas | Disallow: /admin/ |

| Permitir acceso a una carpeta específica | Allow: /imagenes/ |

Cómo Afecta Robots.txt al Posicionamiento

Un estudio de 2023 mostró que:

- El 68% de los sitios con errores en

robots.txtperdieron tráfico orgánico significativo. - La corrección de directivas mejoró la indexación en un 42%, lo que demuestra la importancia de una configuración adecuada.

Los motores de búsqueda como Google utilizan el archivo robots.txt para entender cómo deben interactuar con tu sitio. Si las directivas están mal configuradas, pueden impedir que páginas importantes sean indexadas, lo que afecta directamente tu posicionamiento en los resultados de búsqueda.

Herramientas Complementarias para Validación

Combina Labrika con otras herramientas útiles para mejorar tu estrategia de SEO:

- Google Search Console: Te permite verificar el estado de indexación y detectar errores en tiempo real.

- Bing Webmaster Tools: Ofrece información sobre cómo Bing rastrea e indexa tu sitio.

- Validadores de sintaxis online: Herramientas que analizan la sintaxis de tu

robots.txtpara detectar errores comunes.

Casos de Uso Reales

Problema: E-commerce con 15% de páginas duplicadas indexadas debido a parámetros en las URL.

Solución: Implementación de la directiva Disallow: /*?color=* para evitar que los motores de búsqueda indexen variaciones innecesarias de productos.

Resultado: Aumento del 37% en la visibilidad del sitio en los motores de búsqueda en un periodo de 3 meses.

Preguntas Frecuentes sobre Robots.txt

¿Bloquear URLs con robots.txt evita su indexación?

No siempre; para garantizar que una página no sea indexada, es recomendable usar la meta etiqueta noindex además de las directivas en robots.txt.

¿Cómo afecta Crawl-delay al SEO?

Controla la frecuencia de rastreo de los bots, pero Google ignora esta directiva. Es más útil para otros motores de búsqueda como Bing.

¿Es posible usar expresiones regulares en robots.txt?

Sí, desde 2024, algunos motores de búsqueda han comenzado a soportar expresiones regulares, lo que permite configuraciones más avanzadas.

Actualizaciones Recientes en el Estándar

Desde 2024, los principales motores de búsqueda han implementado varias mejoras en el manejo de robots.txt:

- Soporte para expresiones regulares avanzadas, lo que permite configuraciones más específicas.

- Límites de tamaño ampliados para archivos

robots.txt, permitiendo más reglas y configuraciones. - Compatibilidad con UTF-8 sin BOM, lo que facilita la creación de archivos sin caracteres invisibles que puedan causar problemas.

Conclusión

Configurar y optimizar correctamente tu archivo robots.txt es crucial para el éxito de tu estrategia de SEO. No solo ayuda a los motores de búsqueda a entender cómo deben interactuar con tu sitio, sino que también puede prevenir problemas que afecten tu visibilidad en línea. Utiliza las herramientas disponibles y sigue las mejores prácticas para asegurarte de que tu archivo robots.txt esté en óptimas condiciones y contribuya a tu éxito en los motores de búsqueda.

Recomendaciones Finales

A continuación, te ofrecemos algunas recomendaciones finales para asegurar que tu robots.txt esté siempre actualizado y optimizado:

- Revisión Regular: Revisa tu archivo

robots.txtcada vez que realices cambios significativos en la estructura de tu sitio o en tu estrategia de SEO. Esto te ayudará a mantener un control sobre lo que deseas que sea indexado. - Pruebas de Validación: Siempre valida tu archivo

robots.txtutilizando herramientas como el Validador de Labrika o Google Search Console para asegurarte de que no haya errores que puedan afectar el rastreo. - Documentación: Mantén una documentación clara sobre las directivas que has implementado en tu archivo

robots.txt. Esto es especialmente útil si trabajas en equipo o si planeas realizar auditorías en el futuro. - Educación Continua: Mantente informado sobre las últimas tendencias y cambios en SEO y en las directivas de

robots.txt. Esto te ayudará a adaptarte rápidamente a cualquier actualización que pueda impactar tu estrategia.

Ejemplo Completo de un Archivo Robots.txt

A continuación, se muestra un ejemplo completo de un archivo robots.txt bien configurado:

User-agent: *

Disallow: /admin/

Disallow: /login/

Disallow: /*?session_id=

Allow: /imagenes/

Sitemap: https://tudominio.com/sitemap.xml

En este ejemplo, se bloquea el acceso a las áreas administrativas y de inicio de sesión, se evita la indexación de URLs con parámetros de sesión y se permite el acceso a la carpeta de imágenes. Además, se incluye la ubicación del sitemap para facilitar el rastreo.

Conclusión Final

El archivo robots.txt es una herramienta poderosa en el arsenal de SEO de cualquier webmaster. No subestimes su importancia; una configuración adecuada no solo protege tu contenido, sino que también optimiza el rendimiento de tu sitio en los motores de búsqueda. Al seguir las mejores prácticas y mantener tu archivo actualizado, podrás maximizar el potencial de tu sitio y mejorar tu visibilidad en línea.